Attention和Self-Attention的区别

1 Attention和Self-Attention的区别

Attention:以Encoder-Decoder框架为例,输入Source和输出Target内容是不一样的,比如对于英-中机器翻译来说,Source是英文句子,Target是对应的翻译出的中文句子,Attention发生在Target的元素Query和Source中的所有元素之间。

Self-Attention:Self-Attention机制与Attention机制的区别在于,Attention主要是指Target与Source的之间的相关性,而Self-Attention指的是Source内部元素之间或者Target内部元素之间的Attention,也可以理解为Target=Source这种特殊情况下的Attention,而不是Target和Source之间的Attention。

两者具体的计算过程基本上是一样的,但是计算对象发生了变化。

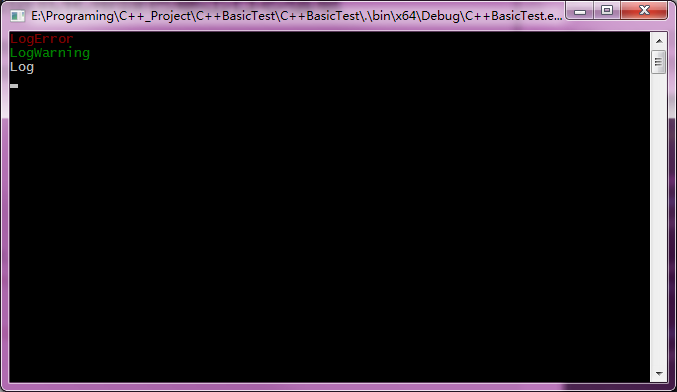

Attention机制可参考下图

Self-Attention机制可参考下图

参考

本文作者:StubbornHuang

版权声明:本文为站长原创文章,如果转载请注明原文链接!

原文标题:Attention和Self-Attention的区别

原文链接:https://www.stubbornhuang.com/3009/

发布于:2024年03月08日 13:43:08

修改于:2024年03月08日 13:51:11

声明:本站所有文章,如无特殊说明或标注,均为本站原创发布。任何个人或组织,在未征得本站同意时,禁止复制、盗用、采集、发布本站内容到任何网站、书籍等各类媒体平台。如若本站内容侵犯了原著者的合法权益,可联系我们进行处理。

评论

71